Vos données d'analyse Web sont-elles faussées par les visites de robots sur votre site ? Si oui, le chroniqueur Ben Goodsell a la solution.

La plupart des SEO ont déjà entendu parler de l'utilisation de fichiers de log pour comprendre le comportement de Googlebot, mais peu semblent savoir qu'ils peuvent être utilisés pour identifier les robots malveillants (ou Bad Bots) qui explorent votre site. De plus en plus, ces robots exécutent du JavaScript, gonflent vos statistiques, utilisent des ressources et dupliquent le contenu.

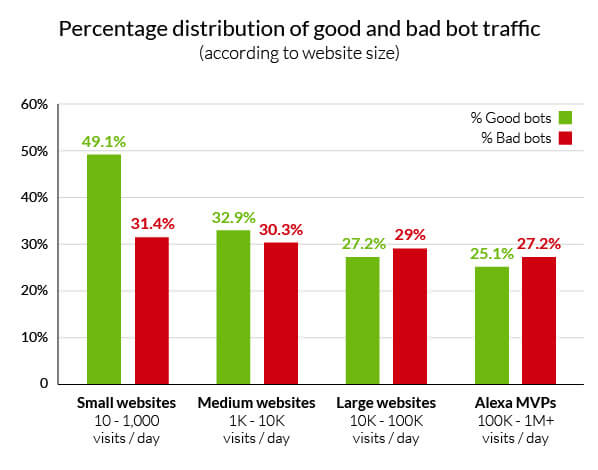

Le rapport 2014 d'Incapsula sur le trafic des robots a analysé 20 000 sites Web (toutes tailles confondues) sur une période de 90 jours et a constaté que les robots représentaient 56% du trafic global des sites Web, et dont 29% était de nature malveillante. Une analyse complémentaire a montré que plus votre marque est importante, plus vous devenez une cible privilégiée pour ces robots.

Bien qu'il existe des services permettant d’automatiser ces actions avec des techniques beaucoup plus avancées que ce qui est montré ici, cet article peut être un point de départ facile (en utilisant Excel) pour comprendre les bases de l'utilisation des fichiers de logs afin de bloquer les Bad Bots au niveau du serveur et d’obtenir des rapports d'analyse.

1. Trouver les fichiers de log

Tous les serveurs conservent une liste des requêtes du site qu'ils hébergent. Qu'un client utilise le navigateur Firefox ou que Googlebot recherche des pages nouvellement créées, toute l'activité sera enregistrée dans un simple fichier.

L'emplacement de ces fichiers de log dépend du type de serveur ou d'hôte que vous avez. Voici quelques informations sur les plates-formes les plus populaires.

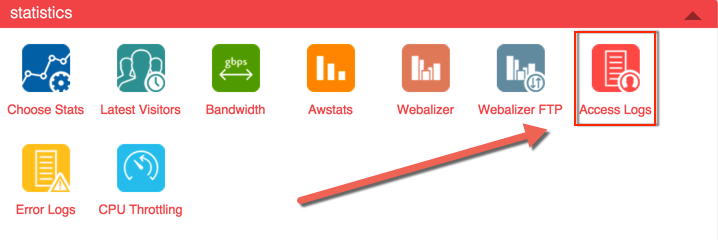

- cPanel : Une interface commune pour les hôtes Apache (voir ci-dessous) qui rend la recherche des fichiers de logs aussi simple que de cliquer sur un lien.

- Apache : Les fichiers de logs sont généralement situés dans le répertoire /var/log et ses sous-répertoires. De plus, l'utilisation de la commande locate access.log permet de repérer rapidement les logs sur le serveur.

- IIS : Les logs des serveurs Microsoft peuvent être activés et configurés dans le Gestionnaire des services Internet.

Allez dans Panneau de configuration -> Outils d'administration -> Gestionnaire des services Internet -> Sélectionner le site Web -> Cliquez avec le bouton droit de la souris sur Propriétés -> onglet Site Web -> Propriétés -> onglet Propriétés générales.

2. Identifiez le nombre de hits par IP et agents utilisateur

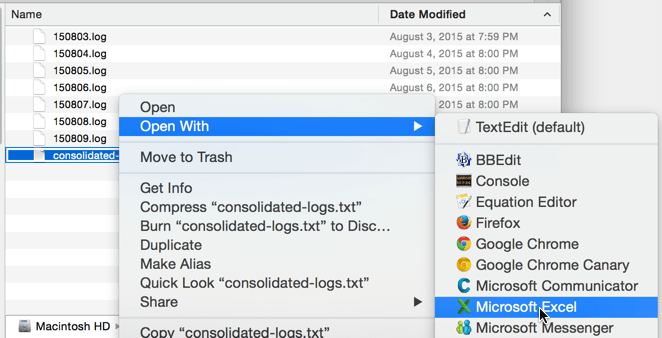

Une fois les fichiers localisés et consolidés, ouvrez-les dans Excel (ou votre logiciel préféré). En raison de la taille de certains fichiers de logs, cela peut souvent être plus facile à dire qu'à faire. Pour la plupart des sites, l'utilisation d'un ordinateur avec une bonne puissance de calcul devrait suffire.

Les fichiers .log ci-dessous ont été regroupés manuellement dans un nouveau fichier .txt à l'aide d'un éditeur de texte puis ouverts et convertis en colonne dans Excel via le délimiteur "espace".

Trouver le nombre de hits par IP

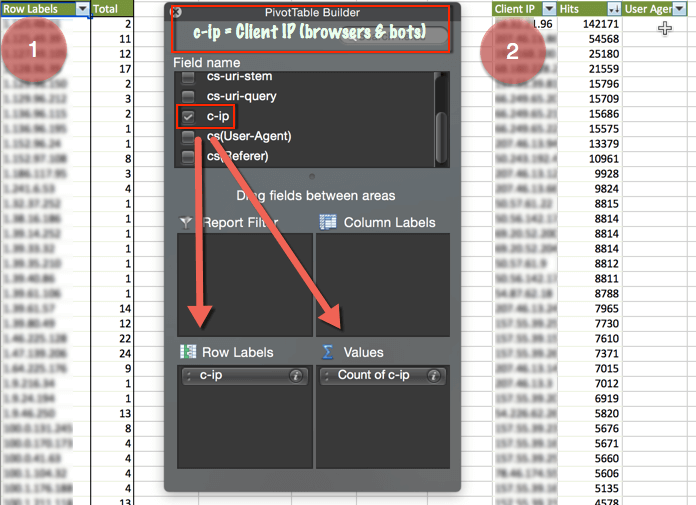

Après la consolidation et l'ouverture des logs dans Excel, il est assez facile de trouver le nombre de hits par IP.

Pour cela :

- Créez un tableau croisé dynamique, faites une analyse sur l'adresse IP client et obtenez le nombre d’occurrences.

- Faites un copier-coller, renommez les en-têtes de colonne en IP client et Hits, triez par ordre décroissant, puis enfin insérez une colonne User Agent à droite de Hits.

Trouver les agents utilisateurs par IP

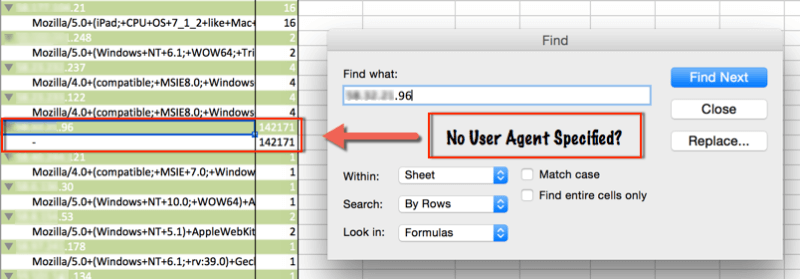

Pour identifier les éventuels Bad Bots, identifiez les agents utilisateurs associés aux adresses IP qui frappent le plus votre site. Pour ce faire, revenez au tableau croisé dynamique et ajoutez simplement l'agent utilisateur à la section étiquette de ligne du tableau croisé dynamique.

Maintenant, trouver l'agent utilisateur associé à l'adresse IP la plus souvent utilisée est aussi simple qu'une recherche de texte. Dans notre cas, l'IP n'a pas d'agent utilisateur déclaré (provenance de Chine) et a frappé le site plus de 140 000 fois.

3. Bloquer les adresses IP pour l’accès au site et l'affichage dans Analytics.

Maintenant que l'adresse IP malveillante a été identifiée, utilisez ces instructions pour ne plus qu’elle fausse les statistiques dans Analytics, puis bloquez cette adresse IP pour qu’elle ne puisse plus accéder au site.

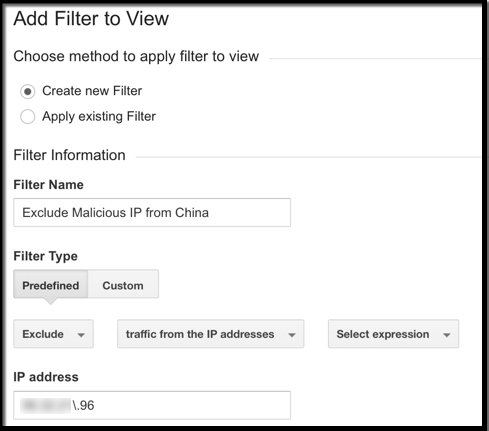

Bloquer une adresse IP dans Google Analytics

En utilisant les filtres de Google Analytics, vous pouvez exclure des adresses IP.

Accédez à Admin -> Choisir vue (c’est toujours une bonne idée de créer une nouvelle vue lorsque vous effectuez des modifications comme celle-ci) -> Filtres -> + Nouveau filtre -> Prédéfini -> Exclure le trafic des adresses IP -> Spécifier l’IP (expression régulière).

Conseil : Google Analytics bloque automatiquement les robots connus identifiés par IAB. Accédez simplement à Admin -> View Settings et sous "Bot Filtering", cochez "Exclude all hits from known bots and spiders". Il est toujours recommandé de créer une nouvelle vue avant de modifier les paramètres du profil.

Si vous utilisez Omniture, il existe trois méthodes pour exclure des données par IP.

- Exclure par IP. Exclut les hits pour une liste d’adresses IP spécifiques (jusqu'à 50 adresses IP).

- Règle Vista. Pour les entreprises qui ont besoin de paramétrer plus de 50 adresses IP.

- Règle de traitement. Il est possible de créer une règle qui empêche d'afficher des données provenant d'adresses IP particulières.

Bloquer une adresse IP au niveau du serveur

A l’instar des fichiers de logs, la méthode de blocage des adresses IP pouvant accéder à votre site au niveau du serveur change en fonction du type de serveur que vous utilisez.

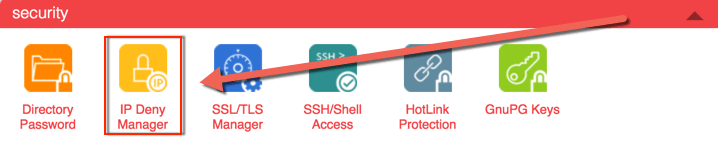

- cPanel : à l'aide de l'IP Address Deny Manager, les adresses IP peuvent être bloquées et gérées en permanence.

- Apache : mod_authz_host est le module recommandé pour cela, mais le .htaccess peut également être utilisé.

- IIS : Ouvrez IIS Manager -> Affichage des fonctionnalités -> Restrictions d'adresses et de domaines IPv4 -> Volet Actions -> Ajouter une entrée à exclure.

Conclusion

Les solutions tierces acheminent tout le trafic à travers un réseau pour identifier les robots (bons et mauvais) en temps réel. Elles ne se contentent pas de regarder les adresses IP et les chaînes d'agents utilisateur, mais aussi les en-têtes HTTP, le comportement de navigation sur le site et bien d'autres facteurs. Certains sites utilisent des méthodes comme reCAPTCHA pour s'assurer que les visiteurs de leurs sites sont bien humains.

Articles qui devraient vous intéresser

Quel hébergeur et hébergement Joomla 3.9 faut-il choisir ?

Quel hébergeur et hébergement Joomla 3.9 faut-il choisir ?

Comment réaliser un formulaire de contact compatible RGPD

Comment réaliser un formulaire de contact compatible RGPD